Acceptabilité de l’Intelligence Artificielle : un vaste chantier

L’intelligence artificielle catalyseur de peurs et de fantasmes

Depuis des décennies, le cinéma – Hollywood en tête – dépeint une image aussi péjorative qu’erronée de l’intelligence artificielle. Tout d’abord, les intelligences artificielles décrites et présentées dans des films tels que Terminator, Matrix ou encore Hal dans 2001, l’Odyssée de l’Espace, sont des IA que nous appelons fortes.

Une IA forte, c’est une IA qui est capable de se généraliser et de réaliser de plus en plus de tâches distinctes. Pour aller plus loin, les IA présentées dans la science-fiction vont même plus loin, pour finalement s’identifier à des singularités. Des intelligences artificielles douées d’une conscience propre et de ce que l’on pourrait appeler un libre-arbitre.

Mais tout cela n’est que pure fiction, au mieux il ne s’agit aujourd’hui que d’une vision théorique, tant nous sommes loin de pouvoir concevoir de telles technologies. Que nous avons même du mal à imaginer.

A l’heure actuelle, nous ne développons donc que des IA “faibles”, des technologies remarquablement efficaces sur des tâches très précises et spécifiques. Aucune d’entre elles ne pourrait se substituer à une autre tant elles sont bornées à une tâche.

Seulement, parler de cette forme d’IA est certes plus conforme à la réalité, mais bien moins vendeur…

Outre le cinéma, les médias ont largement contribué à créer un imaginaire collectif et divers préjugés quant à l’intelligence artificielle. Les différents articles de presse présentent toujours les deux mêmes facettes de l’IA : celle d’une IA enfilant le costume de sauveur de l’humanité et de l’économie, ou bien celle d’une IA qui va asservir l’humain.

Pourquoi ? Parce que qui dit « contenu clivant » dit « clics, vues et ventes à la pelle ». Malheureusement, la recherche de la véracité n’est plus au centre de nos médias. En effet, nous vivons dans une ère mêlant désinformation et course à l’actualité, reléguant la vérification des faits au second plan. Et quand bien même cette vérification est faite, il existe une véritable défiance – plus ou moins légitime – vis-à-vis des grands médias. A cela, il faut ajouter la place grandissante qu’occupent les réseaux sociaux, où l’information et ses sources sont encore plus floues.

Ces phénomènes médiatiques nourrissent les préjugés relatifs à l’IA que nous pouvons retrouver dans la population, allant de la peur aux fantasmes, sans laisser de place à la nuance et la subtilité.

Ainsi, les néophytes ont tendance à humaniser l’intelligence artificielle et redoutent le fait qu’elle puisse prendre des décisions qu’ils ne pourraient comprendre, qu’elle ait des comportements qui nous échappent, qu’elle conditionne nos décisions voire qu’elles prennent le dessus sur l’humain. Dans un réflexe de protection, certains rejettent l’IA en bloc.

Il faut dire qu’actuellement, des nombreuses applications sont aux mains de grandes sociétés et décideurs, ce qui rend difficile l’appropriation du sujet par les particuliers. Outre cet « éloignement », il existe un second problème. Certaines entreprises et personnes vont chercher à utiliser l’IA pour un intérêt purement économique, sans s’orienter vers un cercle vertueux pour l’humanité. En cela, l’acceptation de l’IA par la population semble difficile puisque la technologie ressemblerait à un nouveau mode de contrôle.

Si certaines applications peuvent questionner éthiquement parlant, voire faire froid dans le dos, toutes les mettre dans le même sac n’aurait aucun sens. Comme pour de nombreux sujets, les amalgames sont dangereux.

Qu’est ce que l’acceptabilité ? Une définition rapide du concept

La question posée en creux est celle de son acceptabilité. Au sens littéraire, l’acceptabilité se définit comme le “caractère de quelque chose qui est plus ou moins tolérable” (source Larousse). Dans le cas de l’IA, il s’agirait plutôt à la mesure dans laquelle un système est susceptible d’être en « adéquation avec les pratiques, les ressources, les objectifs, le système de valeurs et les normes éthiques des utilisateurs pour être acceptable (Dubois et Bobillier-Chaumon, 2009 ; Nielson, 1993) ». L’acceptabilité d’une IA est étroitement liée au système social dans laquelle elle est déployée. On parle alors d’acceptabilité sociale. Cette notion, est encore jeune, émergente et la définition ne fait pas consensus.

Citons toutefois Robert Boutilier qui la définit comme : « l’acceptabilité sociale est enracinée dans les croyances, les perceptions et les opinions de la population locale et d’autres intervenants sur le projet. Elle est également immatérielle, sauf si des efforts sont faits pour mesurer ces croyances, opinions et perceptions. Enfin, elle est dynamique et non permanente puisque les croyances, opinions et perceptions sont susceptibles de changer, d’où la nécessité d’acquérir et de développer l’acceptabilité sociale. Ainsi, l’acceptabilité sociale existe dès lors qu’un projet reçoit l’approbation continue des communautés locales et autres parties prenantes. »

Qu’est ce qui rend une intelligence artificielle acceptable ?

Pour qu’une IA soit acceptable, il faut donc que la population partage des perceptions et opinions communes et positives concernant l’intelligence artificielle. A l’heure actuelle, on observe que les avis sont très partagés quant aux risques et bénéfices associés à son utilisation. Un consensus semble toutefois se dégager : la population plébiscite le développement d’intelligences artificielles responsables, éthiques et compréhensibles par l’humain.

En effet, la peur de l’IA provient principalement de l’opacité de son fonctionnement et des données qui ont été utilisées pour son apprentissage. Cette crainte peut être levée par la mise en avant de l’explicabilité de l’IA. Celle-ci peut se comprendre du point de vue de la technique et de la société.

La dimension technique : transparence et explicabilité

Ce que l’on appelle la transparence en Intelligence Artificielle est un concept plutôt large. Un concept qui fait écho à la difficile explicabilité des résultats donnés par les modèles d’IA mais aussi à la transparence du code informatique et des données utilisées.

Certains modèles de Deep Learning sont extrêmement complexes, comptant plusieurs milliers, millions voire milliards de paramètres. Il est donc difficile de retracer le cheminement menant au résultat donné. Cette opacité est d’ailleurs à l’origine du concept de “boîte noire”, largement repris et utilisé pour qualifier l’incapacité de l’humain à comprendre les processus internes d’un modèle de Deep Learning.

Ce manque d’explicabilité et l’incompréhension humaine nourrissent la crainte d’une technologie intelligente capable de prendre des décisions seule et de se soustraire au contrôle humain.

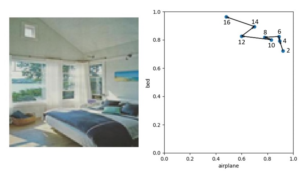

Néanmoins cette problématique est bien connue et la communauté scientifique de l’intelligence artificielle s’attèle à y remédier. Nous pouvons, par exemple, citer les travaux relatifs au Concept Whitening. Cette méthode, intégrée dès la conception du modèle, permet de représenter le cheminement du réseau de neurones de manière plus intelligible par l’humain. Un pas en avant notable !

Une chose paraît certaine, l’explicabilité des résultats sera l’une des clés de voûte d’une IA acceptable.

Mais l’explicabilité n’est pas le seul challenge auquel fait face l’IA, il y a également des aspects de transparence concernant les données utilisées et les codes sources. En effet, il est important de pouvoir expliquer quelles données ont été utilisées et comment elles ont été collectées. Est-ce fait à l’insu de la population ou avec son plein consentement ? De plus, sans visibilité sur les données utilisées, comment s’assurer que le jeu de données ne soit pas fortement biaisé ? Il faut savoir qu’un biais dans la base de données d’apprentissage aura forcément des répercussions et viendra fausser les résultats donnés par l’IA.

Consciente de cela, l’Union Européenne souhaite trouver des solutions via son AI Act. L’une des mesures phares consiste à demander les bases de données exhaustives qui ont servi à l’entraînement d’une IA mise sur le marché.

Toutefois, l’intelligence artificielle est un marché mondial, comportant des enjeux géopolitiques très importants. De ce fait, ce besoin de transparence, demandé par la population, ira probablement contre les intérêts de grandes puissances économiques. Que fera Apple si l’UE lui demande de fournir les données qui ont permis de créer Siri ? Idem pour Google et Amazon ? Outre le travail pharaonique que cela demanderait à tous les acteurs de l’IA, nous risquerions d’être surpris par certaines pratiques utilisées par les géants du numérique.

Il est aussi à noter qu’un système entièrement explicable ouvre la porte à la possibilité de le duper de manière malveillante. En effet, si un système se veut totalement transparent, toute personne pourrait avoir accès à ses rouages, comprendre son fonctionnement et donc le détourner plus facilement. Pour certaines applications et cas d’usages critiques, relevant notamment de la sécurité, une transparence totale ne serait donc pas forcément souhaitable.

La dimension sociale : Acceptabilité sociale, pédagogie et usages

Il existe donc des problématiques – d’ordre technique – à régler pour rendre l’IA intrinsèquement plus acceptable. Mais ce ne sera probablement pas suffisant.

Hormis les enjeux techniques, l’intelligence artificielle se heurte à de fortes croyances, bien ancrées dans l’imaginaire collectif. Pour les défaire, et modifier la perception de la population, il faudra avoir recours à la pédagogie. A l’heure actuelle, la population a été éveillée et éduquée à l’IA par les films hollywoodiens et les médias mainstream. Pas étonnant que les gens puissent avoir peur de l’IA. Ce n’est qu’en leur expliquant, simplement et concrètement, ce qu’est l’intelligence artificielle et son fonctionnement qu’ils seront à même de se forger une opinion éclairée.

Cependant, la pédagogie n’est pas le seul levier à activer. D’ailleurs, la plupart du temps, expliquer le fonctionnement d’une technologie n’est pas efficace, mieux vaut la présenter via ses usages. Encore faut-il savoir cibler les bons cas d’usages.

Aujourd’hui, l’IA est un simple outil, tout à fait neutre. C’est que nous en faisons qui importe. Ainsi, présenter certains cas d’usages permettra à la population de se forger son avis. Certaines utilisations seront jugées éthiques alors que d’autres seront purement rédhibitoires. Il faut donc confronter l’IA à l’opinion publique pour savoir dans quelle mesure l’intelligence artificielle peut être utilisée ou non, acceptée ou non.

Assez logiquement, les usages les plus “utiles” sont les plus rapidement acceptés. Et quoi de mieux qu’un exemple bien parlant pour illustrer cela ? Prenons donc la reconnaissance faciale, une technologie qui soulève la polémique. L’application qu’en a fait le gouvernement chinois – visant à créer un système de surveillance robuste – a créé un vrai battage médiatique. Pourtant, cette même technologie est très largement adoptée par les utilisateurs de smartphones. Dans ce cas là, la reconnaissance faciale permet de déverrouiller son téléphone sans interaction manuelle. Ce qui rend la technologie acceptable, c’est le gain de temps, même minime. Le gouvernement français souhaite d’ailleurs aller dans ce sens en utilisant la reconnaissance faciale pour permettre aux Français d’accéder à leurs espaces personnels liés aux différents services publics. Ce projet, Alicen, est sous médiatisé. Pourtant, une fois créée, cette technologie pourrait être utilisée d’une façon similaire à ce que fait la Chine.

Autre dimension, celle de l’aspect “bénéfique” de la technologie. A l’aube de leurs avènements, de nombreuses technologies, aujourd’hui répandues, divisaient la population. Ce fut notamment le cas du train, qui vit de nombreux détracteurs virulents lui associer des maux farfelus comme l’inflammation de la rétine : avec la vitesse, l’œil voit un trop grand nombre d’images et se fatigue… L’IA n’y échappe pas. Or, avec une certaine prise de recul, il est possible d’estimer assez finement le bénéfice qu’en tirent les utilisateurs. Reprenons l’exemple de la reconnaissance faciale et imaginons que certaines villes la déploient. Admettons que dans ces villes la sécurité augmente conjointement avec la qualité de vie. Le bénéfice apporté par cette technologie sauterait alors aux yeux et cette application deviendrait beaucoup plus acceptable qu’à l’heure actuelle. En matière de santé, si l’IA pose question quelques réussites marquantes devraient pouvoir pour effacer les doutes et renverser positivement l’opinion publique.

La notion d’acceptabilité, déjà complexe, ne se simplifie pas une fois appliquée à l’IA, loin de là. Comme toute nouvelle technologie, nous manquons à la fois de connaissances et de recul quant aux risques et aux bénéfices inhérents à certaines applications. S’il est important de définir un cadre éthique au développement et l’usage de l’intelligence artificielle, ce n’est qu’en la confrontant à la population et en l’utilisant que nous pourrons réellement statuer – en connaissance de cause – sur son acceptabilité.

Notes et sources :

- 1. Lahoual D. & Fréjus M. (2018), Conception d’interactions éthiques et durables entre l’humain et les systèmes d’intelligence artificielle. Le cas de l’expérience vécue des usagers de l’IA vocale. Revue d’intelligence artificielle – n° 4/2018, 417-445, p. 421

- 2. Boutilier & al. “What is Social License?”, 2019