IA COGNITO – EP01 – Démystification de l’IA

L’Intelligence Artificielle, ou IA pour les intimes, beaucoup de gens en parlent sans pour autant vraiment savoir ce que c’est. Des cultissimes films de science-fictions au sensationnalisme journalistique, beaucoup de fausses idées ont circulé et circuleront. Dans ce grand brouhaha, difficile de s’y retrouver et de comprendre concrètement ce qu’est l’IA.

Voilà donc le pourquoi du comment nous vous proposons ce podcast. Mais pourquoi nous ? A Neovision, nous nous sommes donnés une mission : “mettre l’intelligence artificielle à la portée de tous”. Cette mission découle de deux convictions profondes : premièrement, toute innovation technologique doit être accompagnée de pédagogie, et deuxièmement, cette pédagogie doit être distillée par de vrais spécialistes.

A la suite de cette écoute, vous devriez avoir une vision claire de ce qu’est l’IA et outre le fait de pouvoir vous la raconter lors d’un dîner mondain, vous serez capable d’exercer un regard critique sur les informations que l’on vous servira.

De plus, et ça, c’est la cerise sur le gâteau, vous pourrez poser vos questions en commentaires et compter sur des réponses d’experts Neovision.

Petite histoire de l’intelligence artificielle

L’intelligence artificielle dans la science fiction

C’est dans la science-fiction que nous avons entendu parler pour la première fois de technologies dotées d’intelligence. Ne répondant pas encore au nom “d’intelligences artificielles”, elles n’en démontrent pas moins des compétences similaires.

L’élément historique déclencheur de cette fascination pour les machines intelligentes, provient très certainement de la Révolution Industrielle, ou devrions nous dire, les Révolutions Industrielles, qui débutèrent au XVIIIe et se terminèrent au XXe siècle. Cette longue période marqua un tournant pour les hommes du monde entier, qui, habitués à un monde agricole et artisanal, s’adaptèrent à un monde commercial et industriel. Les machines évoluant au fil des décennies, nous pouvons constater que l’image que l’homme se fait de la machine est assez onirique. C’est de cette imagination que naquirent les plus belles œuvres de science fiction sur l’IA. Parmi les plus connues nous pouvons citer L’Eve Future d’Auguste de Villiers de l’Isle Adam publié en 1886, R.U.R, pièce de théâtre écrite par le tchèque Karel Capek en 1921, le célèbre cycle des Robots écrit par Isaac Asimov publié dans les années 50 ou plus récent Défaillances Systèmes de Martha Wells publié en 2017.

Le monde du cinéma fut également inspiré. Ce fut le cas de Stanley Kubrick, réalisateur du film 2001, l’Odyssée de l’espace apparu en 1968, George Lucas, réalisateur de Star Wars, qui sortit le premier volet de la saga en 1977 ou plus récemment Charlie Brooker, auteur de la série Black Mirror sortie en 2011 sur Netflix. Dans chacune de ses œuvres nous pouvons remarquer une toute-puissance des machines, une perte de contrôle de la part de l’humain ou une utilisation malveillante de ces dernières. L’homme est animé par la curiosité et la crainte de l’évolution de ces dernières.

Et en réalité ?

Historiquement, il est très difficile de donner un point de départ à l’IA. Certains disent qu’il faut remonter à l’Antiquité, d’autres seulement au XXe siècle. Aujourd’hui le point de départ que nous allons prendre est la création des processus d’automatisation, car pour nous algorithmes et automates sont les matières premières de l’IA.

Le terme “automate” est utilisé pour désigner plusieurs éléments. On appelera automate tout dispositif permettant de reproduire des séquences de façon autonome. Mais on emploiera également ce mot pour parler d’un modèle de calcul créé grâce à une succession d’états.

Aujourd’hui, il n’existe pas encore de consensus sur la naissance de l’IA. Pour certains, cela a démarré avec les tisserands de Lyon au XIXème siècle et l’automatisation de leurs usines.

Nous commençons plutôt notre chronologie au XXVIIIe siècle, soit un siècle plus tôt, en 1737 lors de la création du premier automate. On le nomma “fluteur” et avait la capacité de jouer onzes aires de musique, ce qui, à l’époque, était vraiment incroyable. Le premier programme informatique fut, quant à lui, développé par une femme, la comtesse anglaise Ada Lovelace en 1843. Peu citée, les programmeurs connaissent pourtant très certainement le langage Ada.

Quelques décennies, remplies d’innovations, passèrent, nous propulsant dans les années 40-50 où des recherches en neurologie sont menées. On s’intéresse alors au cerveau humain et aux connexions neuronales, nous amenant à penser que nous pourrions créer un cerveau artificiel. En 1950, Alan Turing créa une machine de calcul dite “intelligente”, c’est l’une des premières fois que l’on parla de machine intelligente. Elle donna naissance au célèbre test de Turing. A cette période les chercheurs de tout domaine confondu commençaient à avoir accès aux ordinateurs et pensaient qu’en adaptant un langage, à la fois compréhensible par l’homme et par la machine, c’est-à dire avec des symboles, des chiffres, des calculs simples, ils pourraient construire des machines capable de penser. Ce fut le début de ce que l’on appellera le raisonnement symbolique, l’IA symbolique ou encore, quelques années plus tard, GOFAI (Good Old-Fashioned AI).

Vient à présent une date clé de l’IA, 1956, où elle est reconnue comme étant officiellement une science. A l’occasion d’une conférence sur les machines pensantes au Darthmouth College, Joseph McCarthy, considéré comme le père de l’IA, Marvin Minsky, Nathan Rochester et Claude Shannon présentèrent leurs travaux et prononcèrent pour la première fois les mots ”intelligence artificielle”. Leurs recherches étaient basées sur l’observation de l’intelligence humaine dans le but de faire reproduire certaines activités à des machines. Aussi, lors de cette conférence, Allen Newell, Herbert A. Simon et Cliff Shaw présentèrent Logic Theorist, le premier algorithme d’IA capable de faire des démonstrations mathématiques de façon autonome. Suite à cet événement, l’IA connut un essor considérable. Un an plus tard, Franck Rosenblatt, psychologue américain, donna naissance au perceptron, le premier réseau de neurones, accompagné d’un algorithme d’apprentissage supervisé (c’est-à-dire sur un jeu de données annotées). La même année, Noam Chomsky, linguiste américain développa des modèles de langage pour que la machine puisse traiter le langage humain. En 1965, le MIT conçu Eliza, une psychologue artificielle. Cette IA fut la première à réussir le test de Turing.

Puis au début des années 70, l’IA connaîtra une première période d’hibernation, nommée “Hiver de l’IA”. L’Etat américain décida de suspendre les fonds car les recherches en IA rencontraient finalement beaucoup de limites et n’étaient plus assez convaincantes. La puissance de calcul demandée pour des algorithmes d’IA était trop importante. Les différents investisseurs et le Royaume-Uni en firent autant que les USA. Cela contraignit grand nombre de spécialistes à arrêter leurs travaux en IA.

Après une dizaine d’années de trêve, au début des années 80, de nouveaux algorithmes virent le jour : les systèmes experts. Ces programmes permettent de réaliser, de suivre un ensemble de règles successives. En parallèle, le matériel a évolué. De nouveaux PCs, plus performants, sont créés permettant ainsi de réduire les problématiques de calculs liées à l’IA. En 1971, Intel sortit son premier processeur. Malheureusement à la fin des années 80 les coûts de développement et de maintenance des systèmes experts sont trop élevés et l’IA doit faire face à un second hiver. Le manque de données est également un énorme frein dans le développement d’intelligences artificielles. Certains se questionnent même si les recherches sur l’IA vont dans la bonne direction. Est-ce que finalement, l’importance d’un corps jouerait un rôle dans le développement de l’IA ? Pour ceux qui répondent positivement, la réponse serait de creuser du côté de la robotique.

Il faudra attendre les années 90 pour un renouveau de l’IA. Les laboratoires reprennent leurs recherches sur des domaines plus larges que la vision par ordinateur ou le traitement du langage. Mais pourquoi reprendre toutes ces activités tambour battant ? En une dizaine d’années, le matériel n’a cessé d’évoluer, les PCs sont équipés de CPU et GPU permettant une vitesse d’exécution plus rapide, une puissance de calcul plus conséquente et un interfaçage plus ergonomique. Les capteurs, les caméras ont aussi évolué permettant d’acquérir de nouvelles données avec une meilleure qualité. On commence à voir apparaître des solutions cloud permettant de stocker de la donnée en grande quantité. Les années 90 marquent également un nouvel ère numérique car le grand public a désormais accès au Web soit à Internet, un réseau d’informations et de données multiples. Parmi les travaux notoires de cette époque nous pouvons citer ceux de Yann LeCun et de son équipe sur le machine learning et le deep learning. En 1997, nous assistons également à une victoire écrasante pour Deep Blue, un superordinateur entraîné à jouer aux échecs face au champion du monde d’échecs de cette époque, Garry Kasparov. La machine avait battu l’homme, ce qui bluffa le reste du monde.

Enfin, c’est dans les années 2000 que l’IA trouva un nouvel élan. Grâce à Internet et au partage de chacun, les chercheurs et développeurs purent se servir d’un nombre colossal de données variées et de métadonnées. C’est ce que l’on appela plus communément le Big Data. Parmi l’une des plus grosse base de données existantes, nous pouvons citer ImageNet publié en 2010 qui permit de faire des avancées fulgurantes en vision par ordinateur. En 2007, les ordinateurs se miniaturisent et se font appeler smartphones. Aujourd’hui, selon les chiffres publiées en été 2019 par le gouvernement français, plus de 75% de la population possèderait un smartphone. Les objets deviennent connectés, ils sont faciles à utiliser, léger et rapide. On parle d’IA embarqué. En 2015, nouvelle actualité stupéfiante, AlphaGo, une IA capable de jouer au jeu de go bat Fan Hui, un joueur de go professionnel français. Malgré un jeu aux combinaisons bien plus nombreuses que les échecs cette IA a tout de même pu battre l’humain ! Nous avons également découvert les assistants vocaux comme Google Assistant ou Alexa d’Amazon.

Qu’est-ce que l’IA aujourd’hui ?

A l’heure où nous écrivons ces mots, nous nous trouvons au milieu de l’année 2020, et quand nous parlons d’intelligence artificielle, nous révélons d’importantes disparités.

Effectivement, seule une petite partie de la population semble savoir décrire ou donner une définition de l’IA. D’autant plus que, même parmi les spécialistes, les définitions sont multiples. Et par conséquent, nombreuses sont les personnes à ne pas savoir de quoi il s’agit. Certains n’en ont même jamais entendu parlé.

Pour les initiés, nous pouvons identifier deux sous groupes avec des niveaux de maturité différents. Pour le premier, l’IA correspond à des applications concrètes, qu’ils retrouvent déjà dans leur quotidien : reconnaissance faciale, assistants virtuels, véhicules autonomes, détection et reconnaissance d’objets ou encore commande vocale. Le second lui, perçoit l’intelligence artificielle comme un ensemble de technologies qui n’en sont encore qu’à leur balbutiements et attend encore que les promesses soient tenues.

Nous allons donc vous partager notre vision de ce qu’est l’IA en commençant par traiter la question du Machine Learning.

IA = Machine Learning ?

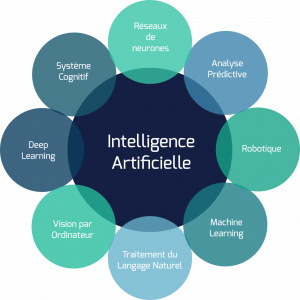

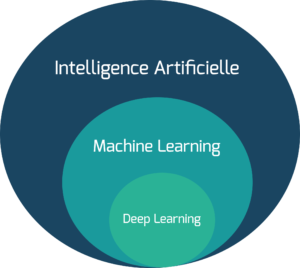

En 2020 donc, lorsque nous évoquons l’intelligence artificielle, on fait bien souvent référence au machine learning – apprentissage automatique dans la langue de Molière – ou au sous domaine du Deep Learning.

Outre le fait qu’elle soit réductrice, cette vision ne respecte pas vraiment l’histoire de l’intelligence artificielle. Pourquoi ? Parce que l’IA n’a jamais cessé d’évoluer, tout comme sa définition.

Alors pourquoi ce raccourci ? La réponse pourrait être plus simple qu’il n’y paraît. Le machine learning a été théorisé au milieu du XXeme siècle, de consort avec le concept d’intelligence artificielle. Il a alors été utilisé jusqu’à la fin des années 90 comme une méthode d’IA parmi d’autres et en fonction des besoins.

Mais alors, d’où vient ce parallèle ? Il faut remonter aux débuts des années 90, le monde de l’informatique, et plus particulièrement sur sa dimension hardware, a connu des progrès significatifs. En a résulté une explosion des puissances de calcul, coïncidant avec l’essor de nouvelles techniques de machine learning.

Mais ce n’est pas tout. Deux autres facteurs peuvent expliquer cette renaissance et ce regain d’intérêt : l’avènement d’Internet et la disponibilité croissante de données à exploiter.

Entre ces deux phénomènes semble exister un lien de cause à effet. Si le développement d’Internet a ouvert l’accès aux données, d’autres innovations ont également accéléré la génération de ces dernières (tel que le développement des PC portables, réseaux sociaux, smartphones…). Aujourd’hui, toute personne – ou presque – résidant sur notre planète bleue génère et consomme des données. Or, les données représentent le carburant par excellence pour le machine learning. De plus, de nombreux travaux ont été menés sur l’annotation des données, comme ImageNet par exemple.

Mais revenons en à Internet. Outre la génération et l’échange de données, une autre dimension aida le développement du machine learning. Comme nous l’avons expliqué précédemment, les puissances de calcul ont explosé. Néanmoins peu d’acteurs sont en mesure de s’équiper de machines extrêmement puissantes puisque ces dernières restent onéreuses. C’est alors qu’apparaissent les acteurs du cloud, offrant accès à une grande puissance de calcul sans avoir à investir. Via Internet et donc le Cloud, les experts de l’IA pouvait ainsi travailler sur des serveurs déportés.

Ainsi, toutes les conditions étaient réunies pour que le machine learning se développe : puissance de calcul décuplée, serveurs et machines virtuelles accessibles, volume de données qualifiées croissant et accessible. Et surtout, toutes ces conditions ont permis de réellement utiliser les capacités d’un domaine particulièrement gourmand du machine learning : le deep learning (ou apprentissage profond).

Voilà donc l’origine du biais selon lequel l’IA se réduirait au machine learning ou au deep learning.

Notre définition de l’IA

Vous l’aurez compris, l’intelligence artificielle est un vaste domaine scientifique que l’on ne peut cloisonner au seul machine learning.

Si le concept d’IA émerge autour des années 50 dans l’esprit d’Alan Turing, John McCarty créa le terme “Intelligence artificielle” en 1956. Et son compère, Marvin Minsky, fondateur du groupe d’Intelligence Artificielle au MIT, en donnait la définition suivante :

“La construction de programmes informatiques qui s’adonnent à des tâches qui sont, pour l’instant, accomplies de façon plus satisfaisante par des êtres humains car elles demandent des processus mentaux de haut niveau tels que : l’apprentissage perceptuel, l’organisation de la mémoire et le raisonnement critique”.

Une définition qui relève un véritable challenge temporel tant les évolutions de l’IA sont nombreuses et variées. Pour preuve, l’apparition de la boîte de vitesse automatique dans les automobiles a constitué pour certains l’une des premières applications concrètes de l’intelligence artificielle.

A Neovision, nous prônons une définition sensiblement similaire à celle énoncée par Marvin Minsky, à savoir que l’IA est un ensemble de technologies informatiques, capables de résoudre des problèmes à haute complexité algorithmiques, et notamment des tâches ques les humains réalisent grâce à leurs fonctions cognitives. Il s’agit donc, pour une grande part, d’automatiser des tâches qui nous sont inconscientes.

A cette définition, il convient également de préciser qu’une IA est un programme informatique capable de traiter un grand volume de données et ce très rapidement. Sur des tâches bien spécifiques et très bien définies, l’intelligence artificielle sera donc plus efficace que l’humain et permet donc d’automatiser et optimiser certains processus.

Dans cette définition, nulle mention n’est faite de l’apprentissage automatique. L’apprentissage automatique, ou machine learning donc, n’est qu’une méthode, un moyen permettant d’atteindre un objectif d’automatisation ou d’optimisation de performances.

Demain, de nouvelles méthodes surpasseront peut être l’apprentissage automatique, de nouvelles applications verront le jour mais le but de l’intelligence artificielle restera le même.

Enjeux, apports et dangers, allons au delà du bullshit

A mort buzzwords et clicbaits : IA, blockchain, quantique et Big Data

L’intelligence artificielle – comme la blockchain, l’ordinateur quantique, l’IoT ou le Big Data – fait partie de ces termes à la mode que l’on nous sert à toutes les sauces. D’une part, parce qu’ils sont synonymes de nouveauté, et ça l’humain, il aime bien, mais aussi parce que ces technologies viennent avec leurs lots de promesses.

Des promesses, l’IA en amène beaucoup, mais elle génère aussi de nombreuses peurs. Forcément, cela fait couler beaucoup d’encre et ça ne date pas d’hier, tant dans la fiction que dans l’information.

Dans l’imaginaire collectif, l’IA n’a pas toujours – voire rarement – une bonne image. La faute à de nombreuses oeuvres cinématographiques de science-fiction offrant une vision peu reluisante de cette dernière. Pêle-mêle nous pouvons citer Matrix, Terminator, I-Robot ou encore 2001 l’Odysée de l’Espace, où l’IA tient un rôle tout sauf humaniste. Or, ces oeuvres cultes forgent des idées pré-conçues et autres préjugés quant à l’utilité et aux risques engendrés par l’intelligence artificielle.

A Neovision, nous défendons une toute autre vision de l’IA, une intelligence artificielle vertueuse qui viendrait assister et augmenter l’humanité. Pour cela, nous vous conseillons d’autres films tels que Her, Wall-E, Iron Man ou Chappie. L’Intelligence artificielle y est dépeinte d’une manière bien plus élogieuse mais aussi plus proche de notre réalité.

Cette hétérogénéité dans le traitement artistique de l’IA permet toutefois de mettre en exergue une certaine ambivalence concernant l’intelligence artificielle, et ce malgré une réelle neutralité technologique.

Autre problème, l’emballement médiatique pour le sujet et la recherche constante du sensationnel au détriment d’un véritable travail d’investigation. Pas un jour ne se passe sans qu’une myriade d’articles portant sur l’IA ne soit publiée.

Or, pour générer des clics ou des vues, rien de plus efficace qu’un contenu clivant. Ainsi, un article présentera les bénéfices de l’IA tandis que le suivant mettra en avant ses potentielles dérives et dangers. Difficile de s’y retrouver.

Pourtant, quand nous nous intéressons aux applications concrètes et actuelles de l’IA, nous la retrouvons sur des tâches très spécifiques sans aucune trace d’une quelconque IA forte (celle que l’on voit toujours dans le film). Les enjeux liés à l’IA sont avant tout économiques et liés à des problématiques d’automatisation et d’optimisation de processus. Nous en savons quelque chose à Neovision puisque nous avons conçu et développé de nombreuses IA sur-mesure. Chaque IA a un rôle bien défini, et est assignée à une tâche pour laquelle elle a été créée. Sur cette tâche, elle est bien plus efficiente que l’humain, et sans le remplacer, cette dernière représente un assistant virtuel de poids.

Pour résumer, l’IA, seule, ne sauvera pas plus le monde qu’elle ne le détruira. Le véritable enjeu repose sur les utilisateurs et leurs desseins. La question est de savoir entre quelles mains seront placées ces technologies et dans quel but.

IA vs humain : introduction à IA et éthique

Dans les fictions comme dans les médias, nous venons donc de voir que l’IA est souvent mise en opposition de l’humain. Ce qui constitue, selon nous, une vision biaisée de ce qu’est l’intelligence artificielle et les bénéfices qu’elle pourrait apporter à l’humain. Le véritable enjeu relatif à l’IA réside dans le rôle que nous souhaitons lui attribuer. De manière générale, et encore plus particulièrement en Europe, l’IA soulève de vrais débats éthiques.

L’IA, de part son essor, est au coeur de contraintes et d’intérêts économiques importants. Ceci va bien souvent à l’encontre de considérations éthiques, ces dernières invitant à une plus grande régulation de l’utilisation de ces technologies. À côté de ça, son explosion récente implique que peu de lois adaptées aux spécificités de l’IA sont en place, créant pour l’instant un vide juridique permettant à nombre d’applications malveillantes de s’y engouffrer. Il est donc plus que nécessaire de s’intéresser clairement à l’éthique de l’IA.

C’est pourquoi nous choisissons d’aborder ce sujet dans un podcast dédié. La définition d’une éthique résulte de discussions. Et ces dernières ne peuvent pas n’être réservées qu’à quelques spécialistes ou dirigeants. Il est nécessaire que l’ensemble de la société s’empare du sujet. C’est pourquoi nous allons chercher à vous donner une vision d’ensemble des problématiques éthiques actuelles liées à l’intelligence artificielle.

Course mondiale à l’IA

L’intelligence artificielle est aujourd’hui convoitée par l’ensemble du globe. Regroupant des enjeux sociétaux, économiques et politiques, nous assistons clairement à une rivalité entre les plus grandes puissances mondiales telles que les Etats-Unis, l’Europe, la Chine, le Japon, la Russie ou encore la Corée du Sud.

En 2019, les États-Unis ont annoncé un budget alloué à l’IA d’une valeur de plus de 52 milliards de dollars sur 5 ans. Leur principale motivation étant de rester compétitifs face à la Chine. En Europe, la Commission européenne a partagé leur souhait d’investir 1 milliard d’euros par an sur la période 2021-2027, soit 7 milliards d’euros pour ces 7 années. A cela s’ajoutant 20 milliards d’euros provenant des investissements publics et privés européens pour favoriser les recherches et le développement en IA. Sur le continent asiatique, la Chine souhaite être le leader mondial de l’IA d’ici 2030, c’est pourquoi elle aurait déjà débloquée plus de 70 milliards de dollars !

Les financements récoltés par chaque leader leur permettent de creuser des sujets d’IA en recherche et développement, faire émerger toutes les possibilité qu’offrent l’IA, développer des solutions IA et, pour les projets les plus aboutis, industrialiser les technologies.

Pour parler plus concrètement de projet mis en place, vous avez très certainement entendu parler de l’American A.I. Initiative lancé par Donald Trump en 2019. Il s’agit d’une initiative permettant de pousser les travaux de R&D en IA aux USA en donnant accès à plus de données, plus de main-d’oeuvre spécialisée, en rassemblant une communauté plus grande de spécialistes. Elle fait également mention de plusieurs directives et normes à suivre et pose les bases sur des questions éthiques. Vous l’aurez compris, l’idée est de distribuer le plus de moyens pour le développement de l’intelligence artificielle dans un cadre défini.

Un autre exemple, celui ci est un peu plus local, c’est le programme IA for Humanity présenté par Emmanuel Macron en mars 2018. L’objectif de cette démarche est de permettre à la France d’être un pays leader de l’intelligence artificielle. Cédric Villani, mathématicien et député de l’Essonne en a rédigé un rapport intitulé “Donner un sens à l’intelligence artificielle pour une stratégie nationale et européenne”. Dans ce rapport, Cédric Villani cible notamment 4 secteurs dans lesquels la France gagnerait à déployer des solutions IA : la santé, la sécurité, la mobilité et l’environnement.

Conclusion

Vous l’aurez donc compris, si l’intelligence artificielle ne date pas d’hier, son développement exponentiel est lui très récent. Cette discipline scientifique a toujours attisé de nombreux fantasmes, aujourd’hui ravivés par les dernières avancées technologiques en la matière.

Si l’intelligence artificielle n’a jamais été aussi prometteuse qu’aujourd’hui, il faut néanmoins relativiser les effets d’annonce et se concentrer sur les technologies concrètes. Les médias aiment à nous présenter une bataille économique et idéologique de rang mondial pour l’IA. Les scénaristes de fiction nous montrent des robots tueurs entremêlés d’ordinateurs vicieux. Toutefois la réalité en est toute autre.

Qu’on parle de machine learning, de deep learning ou autre, le but des scientifiques en IA reste avant tout de trouver des solutions spécifiques à des problématiques précises. Mais nous ne savons pas de quoi demain sera fait. De futures découvertes pourraient donner un nouvel élan à la discipline et ouvrir encore un peu plus le champ des possibles. Mais nous pourrions également nous heurter à une nouvelle barrière et rentrer dans un nouvel hiver de l’IA.

Alors une seule chose à faire : suivre Neovision pour rester au fait des dernières informations sur l’intelligence artificielle sans faire dans le sensationnel !