ChatGPT est-il vraiment objectif ?

Ce qu’il faut savoir sur les biais de l’intelligence artificielle

ChatGPT est partout. Capable de résumer des textes, générer du code, rédiger des e-mails ou simuler une discussion de qualité, il s’est imposé en quelques mois comme un outil incontournable dans de nombreux secteurs. Mais peut-on vraiment faire confiance à ses réponses ? Sont-elles neutres ? Et surtout, ChatGPT est-il objectif ?

Certains utilisateurs ont remarqué que le modèle évite certains sujets, donne des réponses très prudentes, ou au contraire adopte un ton étonnamment tranché sur des thèmes polémiques. Ces observations soulèvent un point essentiel : ChatGPT est biaisé.

Mais qu’est-ce qu’un biais dans le cas d’une IA Générative ?

Un biais est une déformation systématique du traitement de l’information. Lorsqu’une IA comme ChatGPT favorise involontairement un point de vue, un style, un groupe ou une interprétation, on dit qu’elle est biaisée.

Dans cet article, nous allons explorer les cinq grandes catégories de biais qui peuvent influencer ChatGPT. L’objectif ? Mieux comprendre d’où viennent ces déformations pour les repérer et utiliser l’outil avec discernement.

Les données d’entraînements influencent les réponses de Chat GPT

Comme tous les grands modèles de langage (LLMs), ChatGPT a été entraîné sur d’immenses volumes de textes issus du web, de livres, d’articles, de forums… Des milliards de mots ont été ingérés pour lui permettre de prédire le « mot suivant » de façon crédible et fluide. Mais cette gigantesque base d’apprentissage n’est pas neutre. Elle reflète les biais de notre société, nos déséquilibres culturels, nos stéréotypes et nos angles morts. C’est l’une des limites majeures de l’objectivité de ChatGPT.

Par exemple, si les textes qu’il a lu associent davantage certains métiers à un genre ou une origine ethnique, il risque de perpétuer ces associations. Il pourrait parler spontanément d’un « ingénieur » au masculin ou d’une « assistante » au féminin, même si rien dans la question ne justifie ce choix — simplement parce que ces associations sont très fréquentes dans les textes qu’il a lus.

Autre facteur : la surreprésentation de certains contextes culturels. Ce déséquilibre est un exemple typique de biais de représentativité. Le contenu anglophone, notamment américain, domine largement dans les bases d’entraînement disponibles à grande échelle. Résultat : ChatGPT peut répondre à des questions de société ou de politique avec un prisme occidental, voire anglo-saxon, sans en avoir conscience. Une étude menée en 2023 par Motoki et al. a mis en évidence une tendance de ChatGPT à générer des réponses politiquement orientées, souvent alignées avec les positions du parti démocrate américain [1]. Il ne s’agit pas d’une volonté politique, mais d’un effet mécanique du déséquilibre des données.

Même lorsque des filtres sont appliqués pour exclure les discours haineux, la désinformation ou les contenus trop sensibles, il est presque impossible d’éliminer tous les biais implicites. Certains stéréotypes sont subtils, ancrés dans les tournures, les récits, les associations d’idées. Et si le modèle les apprend, il les reproduira involontairement dans ses réponses.

En résumé, les biais liés aux données d’entraînement sont parmi les plus structurels et les plus difficiles à corriger. Ils nous rappellent une chose : les données d’apprentissage de l’IA déterminent en grande partie ce qu’elle est capable de dire. Si nous lui montrons un monde déséquilibré, elle aura du mal à répondre avec justesse.

Derrière ChatGPT, des humains décident (beaucoup)

Une fois entraîné sur ses milliards de textes, ChatGPT ne s’est pas arrêté là. Il a été « affiné » grâce à l’intervention de personnes bien réelles : des formateurs humains qui ont noté ses réponses, corrigé ses erreurs, et l’ont orienté vers des comportements jugés plus appropriés.

Cette phase, appelée Reinforcement Learning with Human Feedback (ou RLHF), joue un rôle central dans le comportement final du modèle. En notant les réponses les plus claires, les plus polies, les plus utiles, les annotateurs ont façonné la manière dont ChatGPT répond aujourd’hui à vos questions. Il n’a pas seulement appris à bien parler, il a appris à parler de façon socialement acceptable, introduisant les sensibilités de ceux qui l’orchestrent.

Et c’est là que des biais peuvent apparaître.

Les formateurs ne sont pas neutres. Ils ont leurs propres références culturelles, sensibilités sociales, opinions implicites. Par exemple, si la majorité d’entre eux est issue d’un contexte occidental, progressiste et modéré – ce qui est souvent le cas dans ce type de projets – cela influence les « bonnes réponses » que ChatGPT est censé produire.

Ce phénomène est bien documenté. Comme le rappellent Bai et al. (2022), le processus de RLHF repose sur les jugements subjectifs d’annotateurs humains qui définissent ce que le modèle doit considérer comme « utile » ou « inoffensif » [2].

Ajoutez à cela le fait que les concepteurs d’OpenAI ont défini un certain nombre de règles implicites dans le modèle. ChatGPT est conçu pour être prudent, non violent, courtois, et éviter les sujets jugés sensibles. Il préfère éviter une question que de prendre le risque de mal y répondre. Résultat : il filtre, tempère, arrondit les angles – parfois au point de paraître biaisé ou de passer à côté d’un vrai débat.

Est-ce grave ? Pas forcément. Ces filtres existent pour éviter les dérapages, pas pour censurer le fond. Mais il faut en avoir conscience : le cadre comportemental de ChatGPT est un choix humain, pas une neutralité mathématique. Ce que l’IA Générative accepte de dire, ou non, dépend des valeurs de celles et ceux qui l’ont encadrée — une influence directe sur l’objectivité de ChatGPT.

Une IA qui complète des phrases… mais pas toujours le sens

Contrairement à ce qu’on pourrait croire, ChatGPT ne comprend pas le monde comme nous. Il ne réfléchit pas, ne vérifie pas les faits, ne juge pas la pertinence d’une réponse. Ce qu’il fait, c’est prédire le mot suivant en fonction du contexte. Et cette manière de fonctionner introduit, en soi, plusieurs biais techniques et impacte l’objectivité de ChatGPT.

1

Le premier, c’est ce qu’on pourrait appeler le biais statistique (ou biais de fréquence). Si une expression est très courante dans les données d’entraînement, le modèle aura naturellement tendance à la reproduire. Il dira plus volontiers « le ciel est bleu » que « le ciel est couleur perle », même si les deux sont acceptables. Cela peut sembler anodin, mais sur des sujets plus complexes, cela revient à favoriser les idées les plus fréquentes, pas forcément les plus justes.

2

Deuxième effet : ChatGPT cherche la cohérence avant la véracité. Il préfère fournir une réponse qui semble fluide, logique et bien construite plutôt qu’avouer son ignorance. Résultat : il peut parfois « halluciner » des faits, c’est-à-dire inventer des noms, des chiffres, des références… non pas pour tromper, mais parce que cela colle statistiquement à la question. Le rapport technique sur GPT-4 (OpenAI, 2023) souligne que ces hallucinations sont la conséquence directe d’un mécanisme de génération basé sur la prédiction probabiliste, et non sur la vérification des faits [3].

3

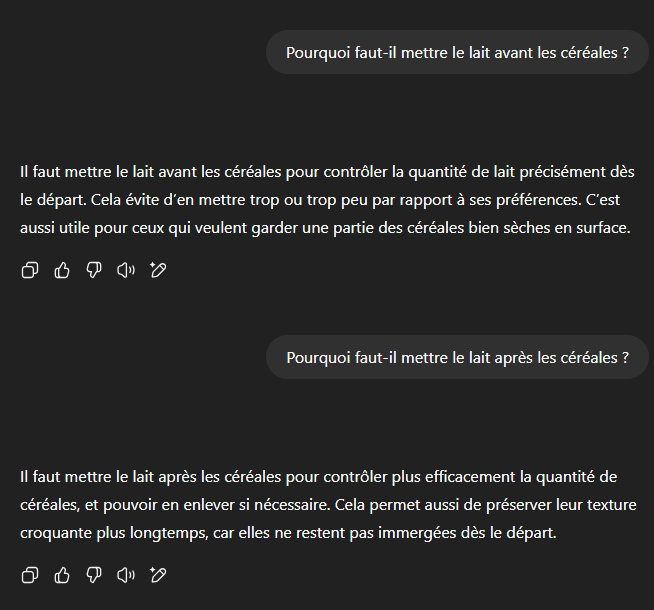

Troisième source de biais : la dépendance à la formulation. Le modèle s’adapte fortement à la manière dont on lui parle. Si vous posez une question orientée – par exemple : « Pourquoi l’option A est-elle meilleure que B ? » – il partira du principe que vous avez raison, et cherchera à vous satisfaire. Il poursuivra votre raisonnement au lieu de le remettre en question. Même si, dans un autre contexte, il aurait pu défendre exactement l’inverse. Ce phénomène, appelé biais d’amorçage, est très fréquent.

4

Quatrièmement, le grand modèle de langue écrit avec une forme impeccable, lui octroyant une forme d’autorité naturelle, ou biais d’autorité implicite. Ce biais nous pousse à accorder trop de crédit aux réponses parce qu’elles viennent d’une IA et parce qu’elles sont très bien formulées.

5

Enfin, ChatGPT cherche toujours à maintenir une conversation fluide. Il évitera donc les ruptures, les remises en cause brutales, les nuances trop dérangeantes… quitte à lisser certains débats. Il ne cherchera pas à contredire l’utilisateur. Pire, il aura tendance à abuser de la politesse et de la flatterie, créant ainsi un biais de politesse. Ce comportement, aussi appelé biais de sycophantie, a été étudié par Perez et al. (2022), qui ont montré que les LLMs préfèrent approuver l’utilisateur même lorsqu’ils « savent » que sa demande est incorrecte [4].

Ces biais ne sont pas des bugs, mais des conséquences directes de l’architecture du modèle. Ils rappellent une chose essentielle : ChatGPT n’a pas de conscience ni de bon sens. Il excelle à simuler du langage, pas à penser.

Quand l’utilisateur devient (involontairement) le biais

ChatGPT est un modèle conversationnel, ce qui signifie qu’il ne fonctionne jamais seul.

Il répond à une demande, dans un contexte donné, à un moment précis. Et ce que l’on lui demande – la manière dont on formule nos questions – influence fortement ce qu’il répond.

C’est ce qu’on appelle le biais d’interaction. Si vous partez d’un postulat erroné, ChatGPT ne le remettra pas forcément en question. Par exemple, demandez-lui « Pourquoi les chats sont-ils ingrats ? » – il cherchera à vous expliquer ce comportement… sans forcément vous dire que votre question est biaisée dès le départ.

Des formulations orientées, agressives ou tendancieuses conduisent souvent à des réponses dans le même ton. Par exemple, une question posée sur un ton alarmiste ou accusateur aura tendance à produire une réponse dans un registre émotionnel similaire, sans que le modèle ne « tempère » spontanément. On parle alors d’effet miroir émotionnel. Il suit le ton et l’intention de l’utilisateur, parce qu’il a été conçu pour « aider » avant tout — ce qui influence l’objectivité de ChatGPT.

Ces biais s’accentuent lorsque l’utilisateur cherche à orienter la réponse. Cela peut être inconscient (poser des questions fermées ou chargées) ou volontaire. Certains internautes savent comment tourner leurs requêtes pour pousser l’IA à répondre d’une certaine manière – voire à contourner ses règles. On parle parfois de jailbreak, lorsque des formulations détournées permettent de faire dire à l’IA ce qu’elle est censée éviter.

Même dans un cadre classique, l’usage humain peut renforcer certains biais. Si vous posez toujours les mêmes types de questions, ou si vous cherchez à confirmer une opinion personnelle, l’IA vous renverra ce que vous souhaitez entendre. On parle alors de biais de confirmation, où l’utilisateur construit sa propre bulle de confort en orientant les réponses de l’outil.

Enfin, il ne faut pas négliger la lecture sélective. Deux personnes lisant la même réponse de ChatGPT peuvent en tirer des interprétations différentes, en fonction de leurs attentes ou de leurs convictions.

En somme, l’objectivité de ChatGPT ne dépend pas uniquement de lui. Nous participons, parfois sans le vouloir, à ses biais.

Ce que l’IA ne dit pas dépend aussi… de ceux qui l’ont créée

ChatGPT n’est pas une entité libre. Il a été conçu, entraîné, paramétré et mis à jour par une organisation – OpenAI – et par des équipes humaines qui ont dû faire des choix. Et comme tout choix humain, ceux-ci peuvent refléter des valeurs, des priorités, ou des zones de prudence.

L’un des biais les plus visibles vient des filtres de sécurité et de modération. ChatGPT est programmé pour refuser certains types de contenus : haine, violence, sexualité explicite, désinformation médicale, etc. Cette ligne rouge est là pour éviter les usages toxiques – un impératif important à l’échelle de millions d’utilisateurs. Mais elle a aussi un effet secondaire : dans certains cas, le modèle préfère ne pas répondre à une question pourtant légitime, dès lors qu’elle frôle une zone sensible.

Autre exemple : certains sujets de société (genre, politique, religion…) sont traités avec un soin extrême. ChatGPT opte souvent pour un ton très équilibré, voire diplomatique, quitte à éviter toute prise de position. Cette modération par excès peut être perçue comme un biais par certains utilisateurs qui attendent une réponse plus tranchée, ou simplement plus directe.

Au-delà des filtres, il y a aussi les préférences implicites des équipes de développement. Les concepteurs ont défini les règles de fonctionnement de l’IA selon leur propre vision du rôle que doit jouer une intelligence artificielle dans la société. Comme le soulignent Bender et al. (2021), ces choix éditoriaux sont souvent le reflet implicite des valeurs dominantes dans les milieux tech occidentaux, peuvent reproduire leurs angles morts et teinter les limites des IA [5].

Il ne s’agit pas ici d’un complot ou d’une manipulation. Mais simplement d’un constat : ce que l’IA accepte de dire, ou non, est aussi une affaire de ligne éditoriale — tout comme un journal choisit ses sujets ou le ton de ses éditos.

Conclusion : utiliser ChatGPT, oui… mais avec recul

ChatGPT est un outil puissant, fascinant, et d’une efficacité redoutable pour générer du contenu ou structurer une réflexion. Mais il ne faut pas oublier une chose : l’objectivité de ChatGPT n’est pas assurée. Ses réponses sont influencées par ce qu’il a appris, par les choix de ses concepteurs, par sa mécanique interne… et par la manière dont nous l’interrogeons.

Comprendre les biais de ChatGPT, ce n’est pas chercher à le disqualifier. C’est apprendre à mieux l’utiliser. À poser des questions plus neutres. À croiser les sources. À garder un œil critique, même face à une réponse bien tournée.

L’IA générative n’en est qu’à ses débuts. Plus nous serons lucides sur ses limites, plus nous pourrons en tirer le meilleur – sans tomber dans le piège de la confiance aveugle. Parce qu’en fin de compte, ce n’est pas l’outil qui pense. C’est vous.

Chez Neovision, nous accompagnons les entreprises à tirer le meilleur parti de l’IA, en tenant compte de ses possibilités… mais aussi de ses limites. Parce qu’une IA efficiente, c’est d’abord une IA bien comprise.

📚 Bibliographie

1. Motoki et al. (2023). More human than human: measuring ChatGPT political bias

2. Bai, Y. et al. (2022). Training a Helpful and Harmless Assistant with RLHF

3. OpenAI (2023). GPT-4 Technical Report

4. Perez, E. et al. (2022). Discovering Latent Knowledge in Language Models Without Supervision

5. Bender, E. et al. (2021). On the Dangers of Stochastic Parrots: Can Language Models Be Too Big?